SDXL Turbo和LCM相继发布,AI画图进入实时生成时代:另一种表述方式

机器之心报道

机器之心编辑部

使用一块 A100,出图的延迟只有 200 毫秒。

Stability AI 在本周二发布了最新一代的图像合成模型 Stable Diffusion XL Turbo,这一消息引起了广泛的赞誉。人们普遍认为,以往从图像生成文本的过程从未如此轻松

只需在文本框中输入您的想法,SDXL Turbo 即可快速响应并生成相应的内容,无需任何其他操作。在输入的同时,它可以随时生成内容,无论是增加还是减少,都不会影响其速度

你还可以根据已有的图像,更加精细地完成创作。手中只需要拿一张白纸,告诉 SDXL Turbo 你想要一只白猫,字还没打完,小白猫就已经在你的手中了。

SDXL Turbo 模型的速度达到了近乎「实时」的程度,让人不禁开始畅想:图像生成模型是否可以做一些其他的事情了

有人直接连着游戏,获得了 2fps 的风格迁移画面:

根据官方博客的介绍,SDXL Turbo 在A100上能够在207毫秒内生成512x512的图像(包括即时编码、单个去噪步骤和解码,使用fp16编码)。其中,单个UNet前向评估占用了67毫秒

如此,我们可以判断,文生图已经进入「实时」时代。

这样的「即时生成」效率,与前不久爆火的清华 LCM 模型看起来有些相似,但是它们背后的技术内容却有所不同。Stability 在同期发布的一篇研究论文中详细介绍了该模型的内部工作原理。该研究重点提出了一种名为对抗扩散蒸馏(Adversarial Diffusion Distillation,ADD)的技术。SDXL Turbo 声称的优势之一是它与生成对抗网络(GAN)的相似性,特别是在生成单步图像输出方面。

请点击以下链接查看论文:https://static1.squarespace.com/static/6213c340453c3f502425776e/t/65663480a92fba51d0e1023f/1701197769659/adversarial_diffusion_distillation.pdf

论文细节

简单来说,对抗扩散蒸馏是一种常用的方法,可以将预训练模型的推理步骤减少到1-4个采样步,同时保持高采样质量,并有可能进一步提高模型的整体性能

为了达到这个目的,研究人员引入了两个训练目标的组合:(i)对抗损失和(ii)与SDS相对应的蒸馏损失。对抗损失迫使模型在每次前向传递时直接生成位于真实图像流形上的样本,避免了其他蒸馏方法中常见的模糊和其他伪影。蒸馏损失使用另一个预训练(且固定)的扩散模型作为教师,有效利用其广泛知识,并保留在大型扩散模型中观察到的强组合性。在推理过程中,研究人员未使用无分类器指导,进一步减少了内存需求。他们保留了模型通过迭代细化来改进结果的能力,这比之前基于GAN的单步方法具有优势

训练步骤如图 2 所示:

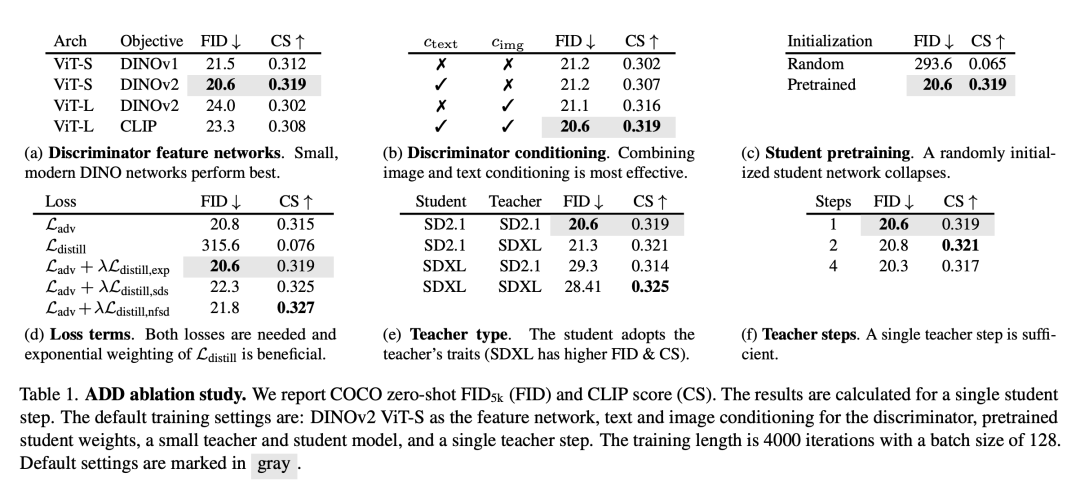

表 1 介绍了消融实验的结果,主要结论如下:

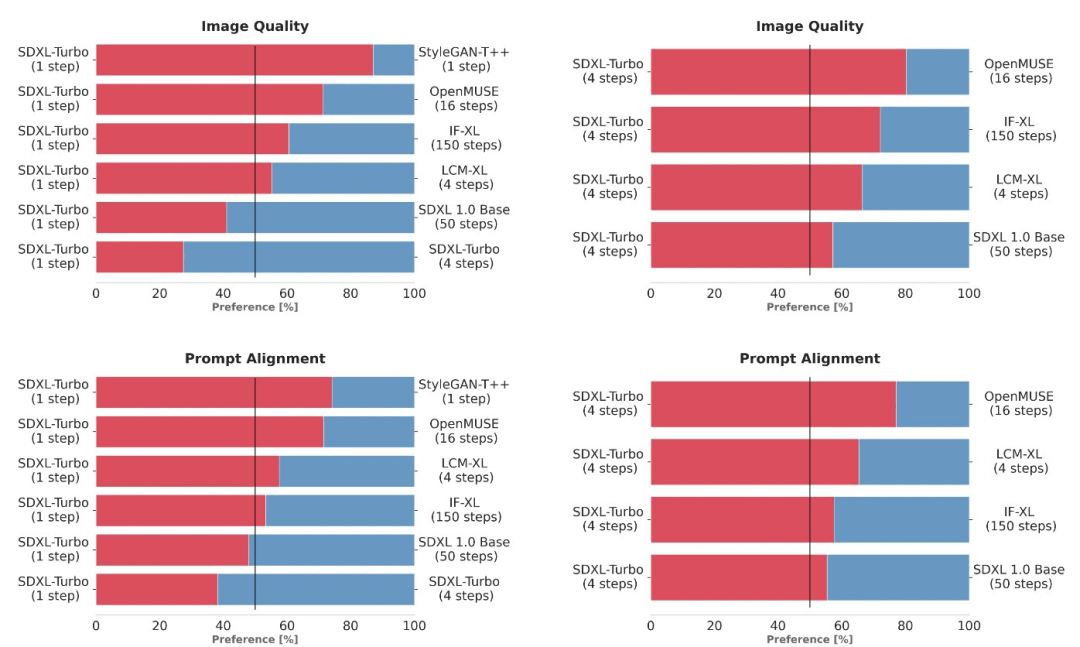

下一步是与其他 SOTA 模型进行比较,本研究采用了更可靠的用户偏好评估方法,而非自动化指标,以评估 prompt 遵循情况和总体图像的程度

实验通过使用相同的 prompt 生成输出来比较多个不同的模型变体(StyleGAN-T 、OpenMUSE、IF-XL、SDXL 和 LCM-XL)。在盲测中,SDXL Turbo 以单步击败 LCM-XL 的 4 步配置,并且仅用 4 步击败 SDXL 的 50 步配置。通过这些结果,可以看到 SDXL Turbo 的性能优于最先进的 multi-step 模型,其计算要求显著降低,而无需牺牲图像质量。

图 7 可视化了有关推理速度的 ELO 分数。

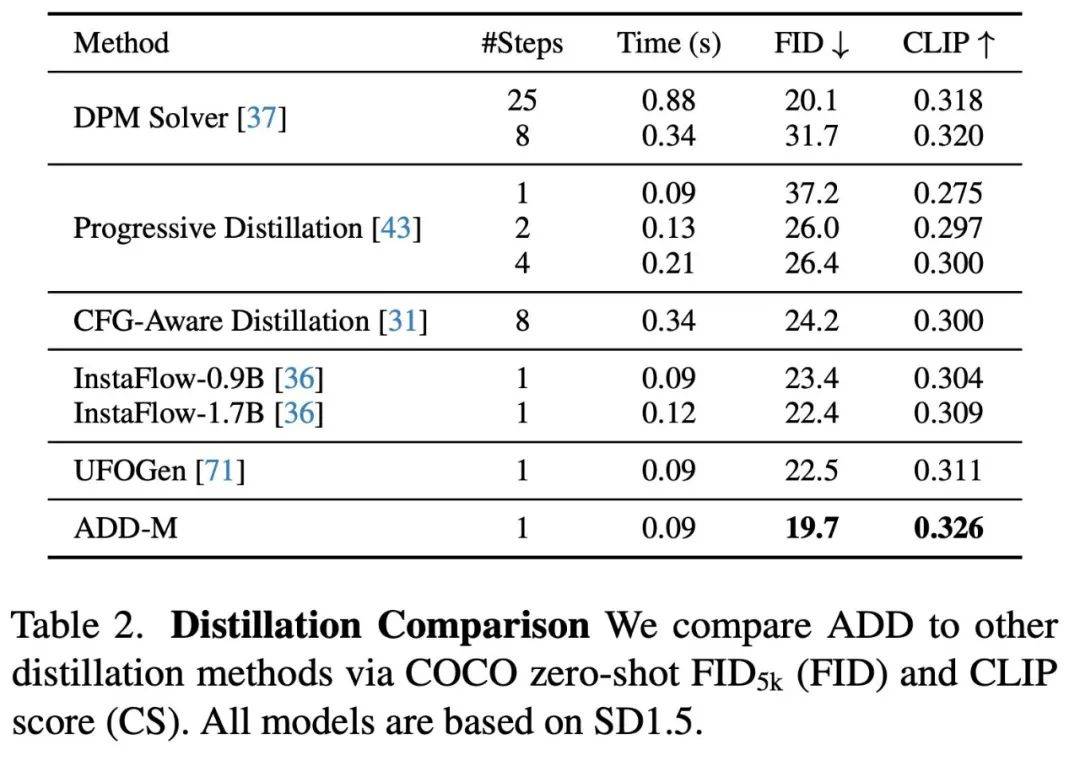

比较了使用相同基础模型的不同 few-step 采样和蒸馏方法后,表 2 显示 ADD 的性能优于其他所有方法,包括 8 步的标准 DPM 求解器

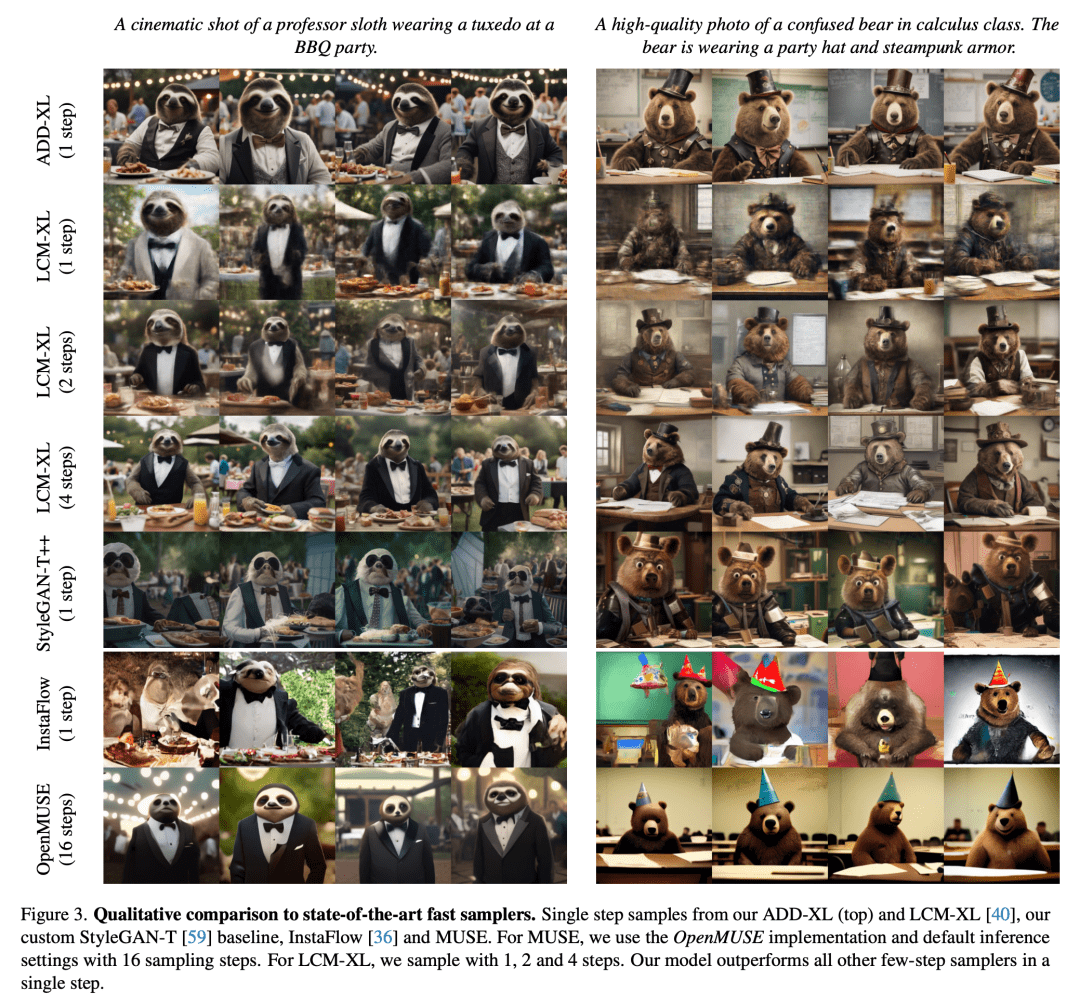

作为定量实验结果的补充,论文也展示了部分定性实验结果,展示了 ADD-XL 在初始样本基础上的改进能力。图 3 将 ADD-XL(1 step)与 few-step 方案中当前最佳基线进行了比较。图 4 介绍了 ADD-XL 的迭代采样过程。图 8 将 ADD-XL 与其教师模型 SDXL-Base 进行了直接比较。正如用户研究所示,ADD-XL 在质量和 prompt 对齐方面都优于教师模型。

更多研究细节,可参考原论文。

本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。